Cómo entiendo algoritmos y toma de decisiones

Veo los algoritmos como recetas: una lista de pasos que siguen reglas y números. Pienso en ellos como herramientas que procesan datos y devuelven sugerencias; muchas veces operan como decisiones algorítmicas invisibles que reorganizan opciones sin que lo notemos. No son magia; son procedimientos que repiten patrones que encontraron antes.

La toma de decisiones mezcla razón humana y señales técnicas. Los algoritmos aportan opciones rápidas y gran cantidad de información; la intuición, los valores y el contexto humano ponen el sello final sobre la elección. También reflejan a quienes los crean y los datos que reciben: si el conjunto de datos tiene sesgos, las sugerencias los llevarán —por eso me interesa la ética de crear inteligencia sin alma. Me pregunto a menudo quién programó la receta y con qué ingredientes; a veces esa ausencia de brújula moral recuerda el vacío moral entre máquina y diseñador.

Lo que explico sobre algoritmos y toma de decisiones

Explico que los algoritmos facilitan tareas repetitivas y muestran patrones difíciles de ver a simple vista. Uso ejemplos claros para mostrar cómo pueden acelerar decisiones pero también simplificarlas demasiado. Mi punto es que sirven, pero no deben sustituir la deliberación humana.

Además, la responsabilidad sigue siendo humana: quien diseña, prueba e implementa tiene influencia enorme. Pedir transparencia y revisar resultados es parte de nuestro trabajo como ciudadanos y consumidores; muchas veces lo que no se dice pesa, como describe lo que no se cuenta sobre los sistemas.

Ejemplos simples que observo en la vida diaria

Veo recomendaciones de música que cambian mi humor; a veces acepto la lista sugerida y otras la ignoro por nostalgia o curiosidad. Es fácil caer en dinámicas de atención donde plataformas optimizan la interacción —tema que profundiiza la economía de la atención. También noto las rutas del GPS y las ofertas que aparecen al buscar un producto. En el supermercado online me llegan anuncios que parecen leer mi mente. Me detengo y pregunto: ¿esto me ayuda o me empuja hacia algo que no elegiría solo?

Pregunta central: Humanos y algoritmos: ¿quién está tomando realmente nuestras decisiones?

Humanos y algoritmos: ¿quién está tomando realmente nuestras decisiones? Mi respuesta breve: es una relación mixta. Los algoritmos empujan y organizan opciones; los humanos fijamos metas, valores y límites. Pero cuando cedemos sin mirar, el poder real se traslada a quienes crean y controlan esos sistemas.

Por qué me importa la ética de los algoritmos

Me importa porque cada día confío en máquinas para cosas que antes eran humanas: recomendaciones de trabajo, noticias y hasta quién recibe una ayuda. Si no entiendo las reglas del juego, pierdo control sobre decisiones que afectan mi vida. Por eso pregunto y cuestiono: Humanos y algoritmos: ¿quién está tomando realmente nuestras decisiones?

Veo casos concretos donde el algoritmo actúa con prejuicios. Conozco a una amiga que tuvo problemas para alquilar un departamento por cómo apareció en búsquedas automatizadas; ejemplos como ese encajan con casos en los que las decisiones automatizadas afectan oportunidades. Esa historia me golpeó y me hizo pensar en responsabilidad. No quiero quedarme de brazos cruzados mientras el código decide por nosotros.

Finalmente, quiero voz en el proceso. La tecnología debe ser herramienta, no juez. Me esfuerzo en aprender y traducir ideas técnicas a lenguaje humano para que más gente pueda opinar.

Principios éticos que considero esenciales

Transparencia: explicaciones simples sobre qué datos se usan y por qué. Si un sistema me niega algo importante, quiero saber la razón en palabras que entienda.

Equidad: prefiero sistemas que detecten y corrijan sesgos, no que los escondan. En mi trabajo hablo de ejemplos claros para que la gente vea el efecto real en vidas concretas; me interesa cómo el poder suave de las plataformas puede reproducir desigualdades.

Dilemas reales que puedo explicar con claridad

Un dilema común es priorizar velocidad contra veracidad: un algoritmo de noticias puede priorizar clics y propagar información falsa, un fenómeno emparentado con la forma en que las narrativas nos controlan. En salud, ¿dejo que un modelo recomiende tratamientos sin supervisión humana? La automatización ayuda, pero siempre debe haber un profesional que valide.

Cómo aplico la ética de los algoritmos en decisiones prácticas

Pido pequeñas pruebas: reviso muestras de datos, exijo métricas de equidad y busco una persona responsable que responda preguntas. Insisto en simulaciones con gente real y en pasos para corregir fallos antes de poner un sistema en marcha; en mis talleres utilizo dinámicas basadas en escenarios y diálogo real para ver cómo responden las personas.

Cómo identifico el sesgo algorítmico

Identificar sesgo empieza por mirar los resultados con lupa: desagrego por género, edad, barrio y otros grupos. Si la tasa de error es mayor para un grupo, eso es señal clara. Pregunto: ¿por qué a este grupo le va peor? Esa pregunta guía mis pruebas.

También hago pruebas activas: cambio variables en ejemplos controlados —por ejemplo, altero el nombre o el barrio en una solicitud— y observo si la decisión varía. Si pequeños cambios irrelevantes disparan decisiones distintas, sé que hay un proxy problemático en el modelo.

Finalmente, reviso la documentación y la historia del dato: quién recolectó, con qué objetivos y qué etiquetas usaron. Hablo con gente que conoce el contexto; muchas veces lo que no se registró o se asumió deja huellas, como explica lo que no se documenta.

Fuentes del sesgo que reconozco en datos y diseño

En los datos encuentro sesgos por muestreo y por historia: si proceden de prácticas humanas prejuiciosas, el algoritmo aprende eso. También hay etiquetas equivocadas y datos incompletos que crean huecos donde el sesgo se esconde.

En el diseño aparecen sesgos por objetivos y elección de variables: optimizar solo por clics prioriza lo que engancha, no lo que es justo. A veces se usan proxies ligados a raza o clase. La diversidad en el equipo cambia mucho la mirada sobre el diseño; discutir identidad y representación ayuda, como en el debate de publicar versus ser en entornos digitales.

Impactos del sesgo algorítmico que he visto en ejemplos reales

He visto algoritmos de selección de personal que descartaban currículos femeninos por patrones históricos. También casos de reconocimiento facial con errores frecuentes en pieles oscuras que llevaron a detenciones erróneas —una muestra de cómo la ilusión de objetividad puede ser peligrosa. Un pequeño sesgo técnico puede crecer como bola de nieve y cambiar vidas: si a un barrio se le niega crédito, sus datos empeoran y el algoritmo lo penaliza más en el futuro.

Señales claras para detectar sesgo algorítmico

Busco diferencias grandes en rendimiento entre grupos, decisiones inconsistentes ante cambios inocuos, correlaciones inexplicables entre variables sensibles, ausencia de registro o explicación, quejas de usuarios y patrones repetidos que afectan siempre a las mismas comunidades.

Lo que pido sobre transparencia algorítmica

Pido que los algoritmos se expliquen como una receta: ingredientes, pasos y por qué se mezcla cada cosa. Quiero saber qué datos usan, qué peso le dan a cada dato y qué resultados esperan. Esa explicación debe ser clara y accesible, no sólo para ingenieros; pienso en formatos que muestren ingredientes y pasos claros con ejemplos.

También exijo responsabilidades concretas: quién responde si el algoritmo discrimina, quién corrige errores y qué plazos hay para arreglarlos. Transparencia no es un documento bonito; es poder preguntar y recibir respuestas útiles.

Qué significa transparencia algorítmica según lo que leo

Transparencia para mí es trazabilidad: seguir el camino desde un dato hasta una decisión. Necesito ver pasos intermedios y ejemplos reales que muestren cómo se llegó a una conclusión, así como claridad sobre límites y sesgos.

Límites técnicos sobre explicar modelos complejos

Entiendo que algunos modelos son cajas negras: redes profundas con millones de parámetros. No pido magia, sino métodos honestos que expliquen por componentes y muestren cuánto simplificamos al dar una explicación. Valoro explicaciones con ejemplos concretos, visualizaciones simples y métricas claras; estas preocupaciones conectan con la discusión sobre la ilusión de comprensión en sistemas complejos.

Herramientas y prácticas que uso para exigir transparencia

Hago preguntas directas, solicitudes por escrito y comparo respuestas entre proveedores; si no responden, lo comparto en redes o con asociaciones de usuarios. Reviso informes de impacto, pruebo productos con casos reales y pido auditorías independientes cuando puedo.

Cómo protejo mi privacidad y datos personales frente a algoritmos

No dejo mi privacidad al azar: reduzco mi rastro digital, comparto solo lo necesario y reviso permisos antes de instalar apps. Si una aplicación pide acceso a contactos o ubicación sin motivo, la bloqueo o la borro. Prefiero controlar yo qué doy y cuándo lo doy.

A veces hay que decidir entre comodidad y privacidad; busco un equilibrio práctico. Uso herramientas y hábitos que me permiten seguir conectado sin perder el control: cambiar contraseñas, autenticación en dos pasos, restringir permisos de apps, bloqueadores de rastreadores y VPN en redes públicas.

Tipos de datos personales que se recopilan

Recogen datos básicos (nombre, correo) y menos obvios: ubicación, historial de búsquedas, clics y compras. Incluso metadatos de fotos (hora, lugar, dispositivo) ayudan a perfilarme. Además, los algoritmos crean datos inferidos: suposiciones sobre edad, intereses o estado emocional. Muchas de estas huellas quedan como ruido invisible que nos sigue.

Derechos y opciones que puedo ejercer para proteger mis datos

Conozco mis derechos: pedir acceso, corregir, eliminar o limitar el uso de mis datos. Aprovecho las opciones de privacidad en plataformas y solicito mis datos para revisar qué han acumulado. Decido cómo doy mi consentimiento y no acepto todo sin mirar.

Acciones concretas que tomo para cuidar mi privacidad

Cambio contraseñas regularmente; uso autenticación en dos pasos; restrinjo permisos y borro apps que piden datos innecesarios; instalo bloqueadores de rastreadores; uso navegadores con protección y, en redes públicas, una VPN. También practico momentos de desconexión para recuperar perspectiva, inspirados en textos sobre silencio digital y el arte de desconectar sin desaparecer.

Mi visión sobre responsabilidad humana en IA

Veo la responsabilidad humana como la brújula que evita que los sistemas se desvíen. Los algoritmos pueden funcionar con los datos, pero alguien tiene que responder por las consecuencias. Cuando hablo con colegas y comunidades siempre lanzo la misma pregunta: Humanos y algoritmos: ¿quién está tomando realmente nuestras decisiones?

Practico una cultura de responsabilidad en mis proyectos: roles claros, registro de decisiones y canales abiertos con la gente afectada. Un sistema sin responsable humano es como un barco sin timón.

Por qué la responsabilidad humana sigue siendo clave

Los algoritmos fallan en contextos nuevos. He tenido que apagar modelos que reproducían prejuicios. Un humano puede detener la máquina y preguntar: ¿esto es justo? Además, la gente necesita a quién recurrir; la responsabilidad visible construye confianza. Esto conecta con la reflexión sobre el vacío moral que puede dejar la automatización.

Roles humanos que considero indispensables para supervisar resultados

Diseñadores que comprendan consecuencias, auditores que revisen sesgos, operadores que vigilen el día a día y representantes de la comunidad afectada. También responsables legales y éticos que puedan tomar decisiones difíciles. En mi experiencia, un revisor humano cambió decisiones cuando el contexto lo pedía; esas conversaciones son parte de narrar y reflexionar juntos.

Pasos que doy para reclamar responsabilidad cuando falla un sistema

Detengo el sistema si es necesario, documento lo ocurrido, aviso a las partes afectadas y asigno una investigación con plazos. Luego corrijo el modelo o el proceso y publico los aprendizajes. Dejo registro público y canales para reclamos.

Qué sé sobre gobernanza de la inteligencia artificial

Gobernar la IA no es solo poner reglas en un papel; es decidir quién tiene voz cuando un algoritmo afecta la vida de alguien. Me interesa la pregunta práctica: Humanos y algoritmos: ¿quién está tomando realmente nuestras decisiones? La llevo como hilo rojo en mis lecturas y comentarios.

Hay capas de control: leyes nacionales, marcos regionales como la UE, normas técnicas y prácticas internas de empresas. Cada capa actúa con ritmos diferentes. La gobernanza debe proteger derechos y dejar espacio para la innovación: transparencia, auditorías y participación ciudadana. Pienso en cómo el poder de las plataformas debe someterse a marcos claros.

Actores que regulan la IA y que sigo de cerca

Sigo a la Comisión Europea, NIST, agencias de protección de datos, UNESCO y OCDE. También presto atención a empresas grandes y grupos de la sociedad civil. Me mantengo activo en redes y boletines, participo en consultas públicas y comento borradores.

Modelos de gobernanza que comparo a nivel local y global

Comparo modelos rígidos (por ejemplo, UE) con modelos flexibles (códigos de conducta de la industria). Lo ideal, para mí, es combinar límites claros con adaptación rápida: normas fuertes en salud y finanzas; más espacio para experimentar en investigación y cultura.

Formas en que participo o influyo en la gobernanza de la IA

Envío comentarios a consultas públicas, escribo, doy talleres y colaboro con grupos locales. Doy feedback a startups, firmo cartas abiertas y me reúno con responsables políticos para explicar impactos concretos.

Cómo veo la automatización y empleo en mi entorno

Veo la automatización como una ola que ya toca la orilla: tiendas con cajas de autoservicio, almacenes con robots. No se trata solo de máquinas que quitan puestos, sino de tareas que cambian de dueño; a veces pasan a la máquina y otras a personas con nuevas responsabilidades.

Siento mezcla de miedo y curiosidad. Me preocupo cuando la gente pierde empleo sin apoyo, pero me ilusiona ver roles nuevos: analistas de datos, operadores de drones, técnicos de mantenimiento. La pregunta que lanzo en conversaciones es directa: Humanos y algoritmos: ¿quién está tomando realmente nuestras decisiones? Esa duda guía cómo me preparo y cómo hablo con colegas.

Sectores más expuestos a automatización

Logística y transporte, comercio minorista, atención al cliente, banca y finanzas están en primera fila: robots en almacenes, chats automáticos, filtrado de solicitudes y detección de fraudes transforman tareas.

Habilidades que recomiendo para adaptarse al cambio laboral

Reforzar creatividad, juicio ético, comunicación y manejo emocional. Aprender herramientas digitales básicas y pensamiento crítico sobre datos. Practicar hablar en público y escribir claro; un curso de hojas de cálculo o conceptos de datos puede abrir puertas. También ayuda entender el dilema de elegir entre muchas opciones que generan las plataformas.

Políticas y medidas útiles para proteger empleos

Combinar formación financiada por el Estado y empresas, seguros de transición laboral y regulaciones que obliguen a evaluar impactos sociales antes de implementar tecnologías masivas. Incentivos para que las empresas mantengan empleo mientras capacitan a su gente.

Mi enfoque sobre intervención humana en algoritmos y regulaciones sobre IA

La intervención humana no es un lujo, es una obligación cuando los algoritmos tocan vidas. Diseño flujos donde una persona revisa resultados críticos: aprobaciones de crédito, diagnósticos médicos o bloqueos de cuentas. Registro cada paso para auditorías y aprendizaje.

Pongo reglas claras: qué decisiones puede tomar la máquina sola y cuáles requieren firma humana. A veces acepto lentitud para evitar daño; otras dejo actuar al algoritmo cuando el riesgo es bajo. Siempre priorizo la transparencia.

Estrategias de human-in-the-loop que promuevo

Divido tareas según riesgo: revisión humana automática si la confianza del modelo baja de cierto umbral; para lo común, dejo actuar al sistema y registro la acción. Entreno a las personas como parte del algoritmo: paneles claros, ejemplos de fallo y criterios para escalar problemas. Hago simulacros y equipos de “prueba y error” para que se acostumbren a decidir sin perder criterio; prácticas que exploro también en ejercicios de diálogo y entrenamiento.

Regulaciones sobre IA que sigo y que afectan decisiones automatizadas

Sigo leyes de protección de datos y reglas que exigen trazabilidad. Aplico principios como transparencia y derecho a una explicación cuando una decisión afecta negativamente a alguien. En préstamos, por ejemplo, coloco revisiones humanas obligatorias para decisiones que pueden denegar a una persona.

Reflexión final: Humanos y algoritmos: ¿quién está tomando realmente nuestras decisiones?

Humanos y algoritmos comparten la mesa, pero la responsabilidad final debe quedar en manos humanas. Los modelos influyen y empujan, como un viento que mueve una vela; quien ajusta el timón sigue siendo la persona. Si dejamos que el código decida sin control, perdemos la brújula —y es precisamente para evitar eso que vuelvo una y otra vez a preguntar cómo funcionan estas decisiones automatizadas en nuestras vidas.

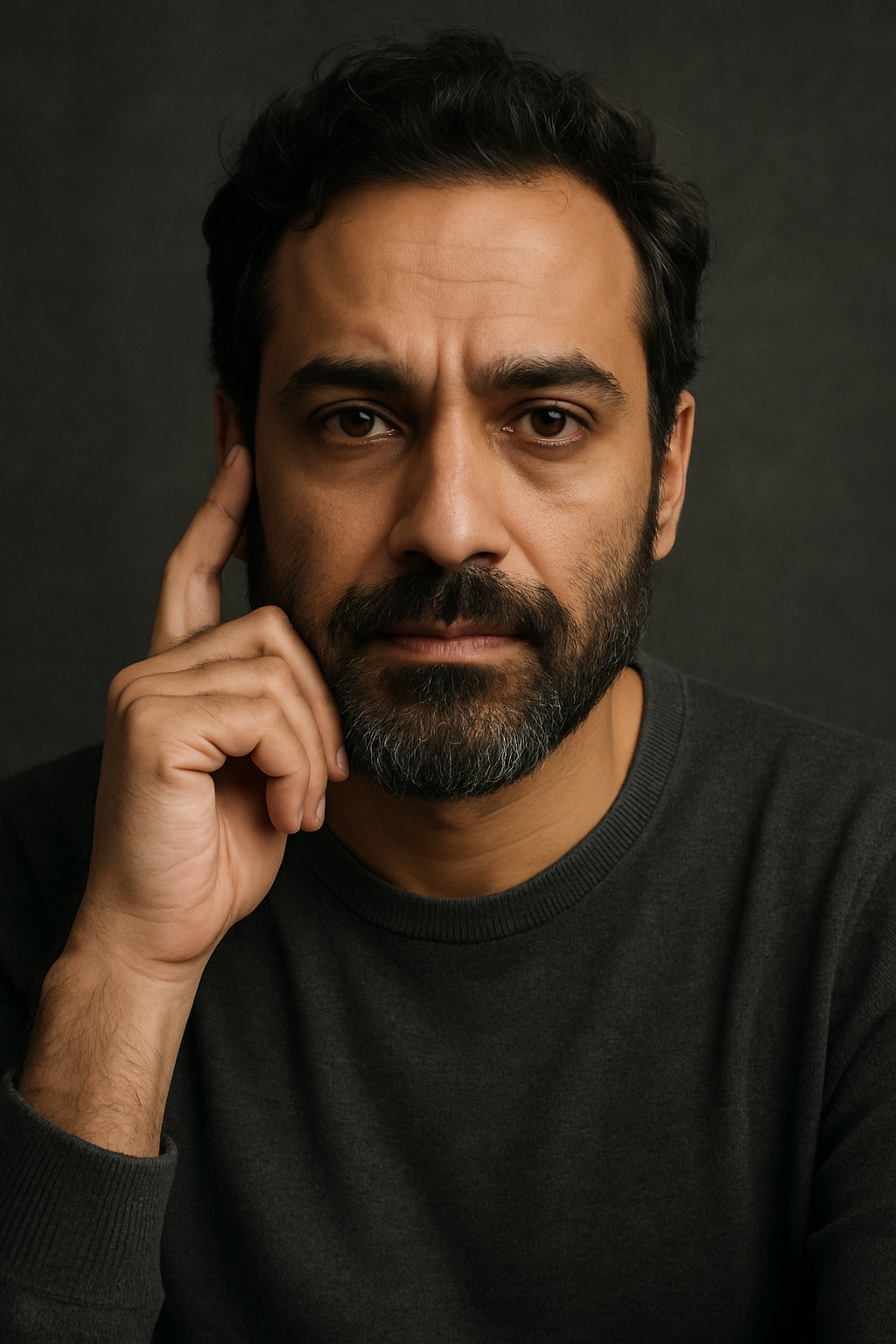

Me llamo Jallim Carrim. No soy filósofo por título, sino por necesidad interior. No escribo para enseñar, sino porque mis pensamientos se niegan a quedarse en silencio.

Durante los últimos años he observado con detalle las pequeñas revoluciones invisibles del alma humana: cómo nos adaptamos, cómo fingimos estar bien, cómo sobrevivimos emocionalmente en un mundo que avanza sin pausa. Con una formación en estudios culturales y comportamiento digital, combino temas como identidad, tecnología, soledad moderna y propósito, siempre con una mirada introspectiva y simbólica.

Este sitio no trata sobre mí. Trata sobre ti, sobre todos nosotros. Sobre lo que pensamos pero no decimos. Sobre lo que sentimos y no entendemos. Sobre lo invisible que nos define.

Bienvenido a este espacio entre el ruido y el silencio.